I den digitala tidsåldern blir artificiell intelligens (AI) mer genomgripande och hittar tillämpningar inom olika sektorer. Nyligen har vi sett framstegen i Googles projekt att generera musik från en enkel "prompt". Idag finner vi det också meta gav sig ut på detta äventyr, skapande språkmodeller som kan generera ljud från en textbeskrivning. Namnet på detta revolutionerande verktyg är 'ljudhantverk".

Meta Audiocraft: en ny horisont för generering av musik tillgänglig för alla (eller nästan)

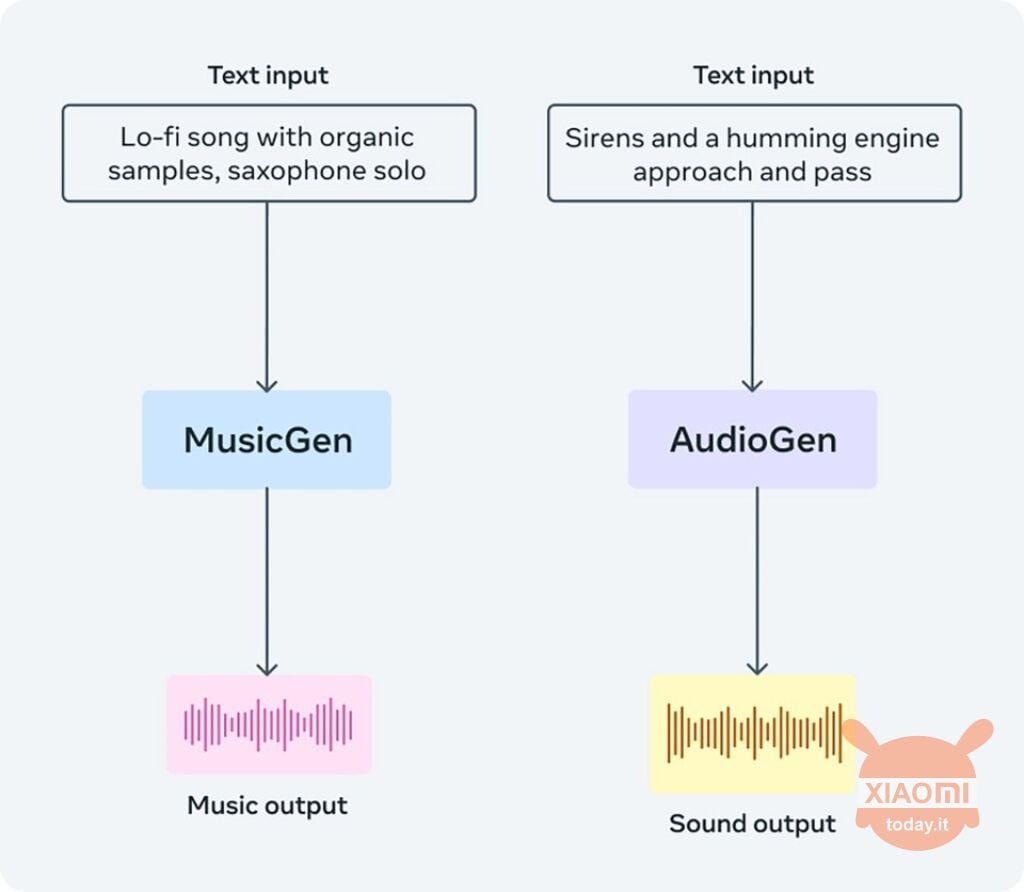

Audiocraft är ett AI-baserat verktyg som använder sig av tre språkmodeller: AudioGen, EnCodec och MusicGen. Målet är att låta användare få ljudspår med utgångspunkt från en enkel textbeskrivning av vad de vill höra. Audiocraft kan användas för att generera både musik och ljud, samt erbjuda komprimeringsmöjligheter.

Bland de tre modellerna, MusicGen är den som är speciellt utbildad för att generera musik från text. För att göra detta användes tusentals musikstycken licensierade av Meta. Den mest spännande nyheten är att alla tre modellerna har släppts öppet källa, vilket innebär att vem som helst kan använda dem för att skapa verktyg och applikationer. Enligt Meta var dessa mallar speciellt utformade för musikartister och ljuddesigners, med syftet att "ge inspiration".

Läs också: Metas nya strategi för riktad annonsering: användartillstånd

Mallarna är redan tillgängliga och deras kod kan laddas ner via Kramande ansikte eller den relaterade sidan Github. MusicGen kan användas för att få AI-genererade låtsnuttar, medan AudioGen kan tillhandahålla användbara ljud för musikproduktion. EnCodec, å andra sidan, är ett AI-baserat komprimeringsverktyg.

För att generera ett musikstycke räcker det beskriv musiken du vill ha och tryck på knappen 'Generera'. Dessutom är det möjligt att komplettera beskrivningen med en ljudfil eller en inspelning av din mikrofon för att låta modellen mer exakt bearbeta den typ av musik du vill generera.

Ljudet som genereras kommer att vara ett spår som är cirka 12 sekunder långt. För att få ett verktyg som kan generera mer kompletta utdrag måste vi vänta på att någon utvecklare bygger en app baserat på dessa mallar. Meta tillhandahålls verktyg, nu är det upp till samhället att ta reda på vad som kan göras med dem.